BLUEPRINTS FÜR HIGH-END-ARCHITEKTUREN

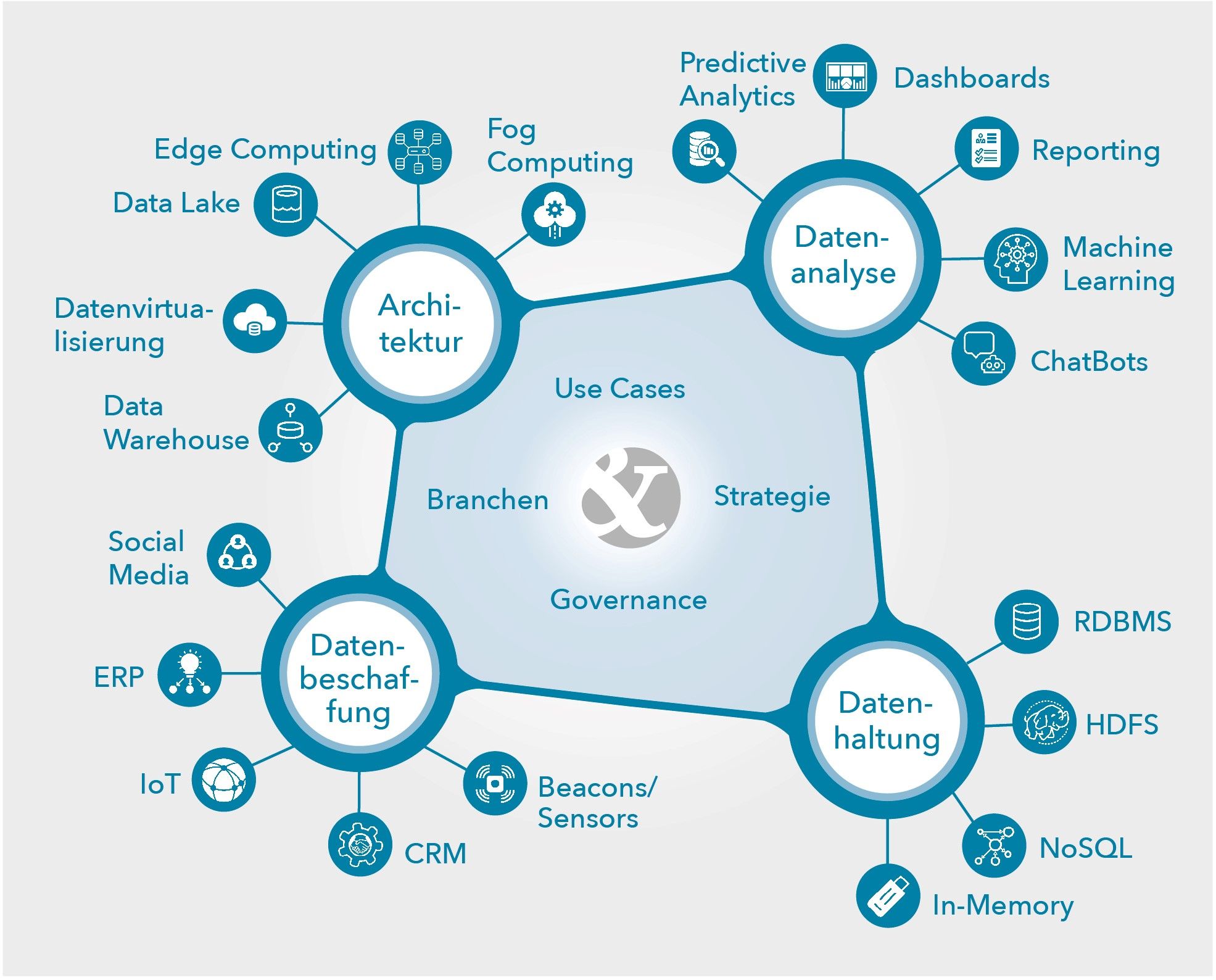

Die schiere Menge analytischer Verarbeitung durch Künstliche Intelligenz erfordert neue Wege der Verteilung von Teilaufgaben bei High-End-Architekturen – von der Cloud bis zum Device.

Neben den klassischen DWH rückt seit längerem immer mehr die Cloud als Umgebung für dispositive Systeme in den Mittelpunkt. Anstelle des althergebrachten DWH werden nun Data Lakes mit den Mitteln und Werkzeugen, die das Hadoop-Ökosystem und verwandte Tools bzw. Technologien (z.B. Spark) zur Verfügung stellen, aufgebaut und ermöglichen die effiziente Verarbeitung riesiger Datenmengen, die nicht zwingend strukturiert sein müssen.

Zudem stehen ausgereifte Werkzeuge zur Echtzeitverarbeitung zur Verfügung und sprengen damit endgültig die festen Ladezyklen von DWH. Lambda-Architekturen ermöglichen dabei das Zusammenbringen von Echtzeitdaten und historischen Daten aus dem Data Lake zu umfassenden Auswertungen. Sie bilden so die Grundlage für weitere Analytik – von Machine Learning bis hin zur künstlichen Intelligenz. Gleichzeitig ermöglichen moderne ereignisgetriebene Architekturen völlig neue Use Cases z.B. aus dem IoT-Umfeld (bspw. Verarbeitung und Analyse von Sensordaten und darauf aufsetzende prädiktive Verfahren).

Cloud-to-Edge Computing

Auch in Zukunft wird die Cloud weiterhin fester Bestandteil solcher Lösungen sein, aber es zeigt sich schon jetzt, dass sie allein nicht in der Lage sein wird, die stetig wachsenden Datenmengen zu verarbeiten. Daher ist eine Vorverarbeitung dieser Daten bereits vor Anlanden in der Cloud notwendig. Diese Vorverarbeitung kann auf den Endgeräten selbst (Edge Computing) und/oder in einer Zwischenschicht zwischen Endgeräten und Cloud erfolgen: dem sogenannten Fog-Layer. Damit setzt sich ein Trend zur Demokratisierung analytischer Verarbeitung konsequent fort und bezieht nicht mehr allein die Datenanalyse in Form von Berichten und Dashboards ein, sondern setzt bereits bei der Datenaufbereitung an.

Event-Driven Architectures

Auch das Thema Virtualisierung als Teilbaustein einer Digitalisierung wird in Zukunft eine stärkere Rolle einnehmen. Virtuelle Maschinen sind seit langem ein Standard, und in den letzten Jahren ist ein Trend zu Containern (Docker und Konsorten) zu verzeichnen. Auch auf der Datenseite ist das Thema Virtualisierung nicht neu, gewinnt jedoch unter dieser Bezeichnung immer mehr an Bedeutung, auch wenn es Virtualisierungen in diesem Umfeld schon seit langem gibt. Die entsprechenden Produkte wie Denodo oder Querona haben einen Reifestatus erreicht, der nicht nur die Zusammenführung vieler Datenquellen an einem virtuellen Ort erlaubt, sondern darüber hinaus Nutzungsszenarien ermöglicht, die es bis dato noch nicht gegeben hat. Hierzu gehören virtuelle DWH oder Process-Mining-Datenstrecken, um nur einige zu nennen. Unterstützt wird dies durch leistungsfähige Cachingmechanismen, mit deren Hilfe auch eine praxistaugliche Performance erreicht werden kann – ein großes Manko früherer Implementierungen und Produkte.

PoC-Umgebung

Die Horn & Company Data Analytics GmbH hat State-of-the-Art-Technologien wie Spark, Amazon SageMaker, Amazon S3, Amazon EMR, Amazon Athena etc. zu einer Referenzarchitektur zusammengeschnürt und ermöglicht in der (AWS-) Cloud die Durchführung von PoC oder PoV. Die existierende Cloudumgebung ermöglicht ein schnelles, effizientes und kostengünstiges Testen und Entwickeln. Damit ist man deutlich schneller und günstiger am Ziel und vermeidet teure Fehlschläge am Ende langer Entwicklungsphasen. Zugleich wird der Mehrwert durch den Einsatz modernster Umgebungen und Werkzeuge rasch deutlich. Die Referenzarchitektur deckt dabei alle Anwendungsszenarien von Echtzeitverarbeitung bis zur KI ab.